Секреты эффективной обработки данных мониторинга: от сбора до анализа

Представьте себе: вы – капитан космического корабля, несущегося сквозь бескрайние просторы Вселенной. Перед вами – бесконечный поток данных о состоянии двигателя, энергосистеме, навигационных приборах. Без эффективной обработки этой информации ваш корабль рискует стать беспомощной консервной банкой, дрейфующей в космической пустоте. Обработка данных мониторинга – это то же самое, только вместо космического корабля у нас бизнес, а вместо двигателей – сервисы, приложения и инфраструктура. Только грамотный анализ данных позволит нам не только избежать «космических катастроф», но и оптимизировать процессы, повысить эффективность и выйти на новый уровень развития. Готовы узнать, как это сделать? Поехали!

Этап 1: Сбор данных – основа всего

Первый и, пожалуй, самый важный шаг – это грамотный сбор данных. Нельзя анализировать то, чего нет, верно? Здесь важно понимать, какие именно данные нам нужны и как их собирать наиболее эффективно. Зачастую, компании собирают слишком много ненужной информации, тратя драгоценное время и ресурсы. Поэтому, прежде чем начинать сбор, необходимо четко сформулировать цели и задачи. Что мы хотим узнать? Какие показатели нам важны? Какие данные помогут ответить на эти вопросы?

Например, если мы мониторим производительность веб-сервера, нам потребуются данные о загрузке процессора, памяти, количестве запросов и времени отклика. Если же мы анализируем поведение пользователей, то сосредоточимся на данных о посещаемости, конверсии, времени, проведенном на сайте, и источниках трафика. В каждом конкретном случае набор показателей будет уникальным. Важно помнить, что качество анализа напрямую зависит от качества исходных данных. Мусор на входе – мусор на выходе.

Выбор инструментов сбора данных

Выбор инструментов для сбора данных – это отдельная большая тема. Рынок предлагает огромный выбор решений, от простых скриптов до сложных платформ мониторинга. Выбор зависит от сложности задачи, объема данных, бюджета и технических возможностей. Некоторые популярные инструменты позволяют собирать данные с различных источников: серверов, баз данных, приложений, устройств IoT и т.д.

Например, можно использовать системы метрик, такие как Prometheus или Graphite, для сбора и хранения временных рядов данных. Для сбора логов можно использовать такие инструменты, как ELK stack или Splunk. A для сбора данных из различных источников и их агрегации можно использовать специализированные платформы мониторинга. Важно выбрать инструмент, который будет соответствовать вашим специфическим потребностям и позволит легко интегрироваться с существующей инфраструктурой.

Этап 2: Хранение данных – надежность и масштабируемость

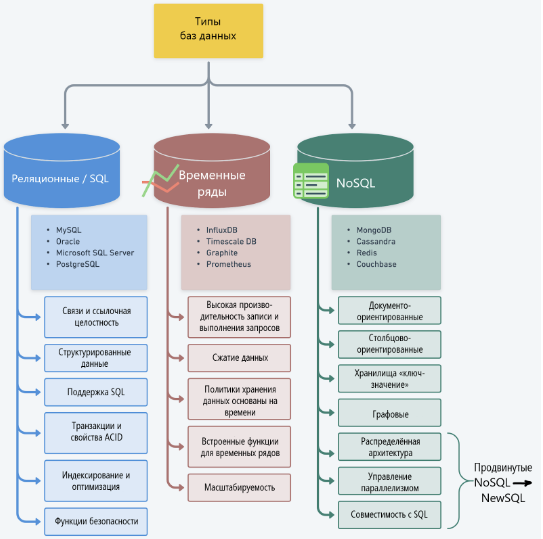

Собранные данные нужно где-то хранить. И этот этап ничуть не менее важен, чем сбор. Необходимо выбрать систему хранения, которая будет надежной, масштабируемой и позволит эффективно осуществлять поиск и обработку данных. Выбор системы хранения зависит от объема данных, скорости доступа, требований к безопасности и бюджета.

На рынке существуют различные варианты: от простых баз данных до распределенных хранилищ данных. Для больших объемов данных, требующих высокой скорости обработки, часто используются NoSQL базы данных или облачные хранилища. Для небольших объемов данных, достаточно может быть обычной реляционной базы данных.

Выбор системы хранения данных

Выбор системы хранения данных – это компромисс между стоимостью, производительностью и функциональностью. Важно учесть следующие факторы:

- Объем данных

- Скорость доступа к данным

- Требования к безопасности

- Масштабируемость

- Стоимость

Ниже представлена таблица, сравнивающая ключевые характеристики различных систем хранения данных:

| Система хранения | Объем данных | Скорость доступа | Масштабируемость | Стоимость |

|---|---|---|---|---|

| Реляционная база данных (MySQL, PostgreSQL) | Средний | Средняя | Средняя | Низкая |

| NoSQL база данных (MongoDB, Cassandra) | Высокий | Высокая | Высокая | Средняя |

| Облачное хранилище (AWS S3, Google Cloud Storage) | Очень высокий | Зависит от конфигурации | Высокая | Средняя — Высокая |

Этап 3: Предобработка данных – очистка и подготовка

Даже самые лучшие данные требуют предобработки. Реальные данные часто содержат ошибки, пропуски, выбросы и несоответствия. Предобработка данных – это процесс очистки, преобразования и подготовки данных к анализу. Это критически важный этап, от которого напрямую зависит качество результатов анализа.

В процессе предобработки выполняется ряд операций: очистка данных от шума и выбросов, заполнение пропущенных значений, преобразование данных в нужный формат, нормализация данных и т.д. Для этого используются различные методы и инструменты, в зависимости от типа данных и задачи. Некоторые задачи можно автоматизировать, используя скрипты или специализированные программы.

Основные методы предобработки

Вот лишь некоторые из методов предобработки данных:

- Удаление выбросов: исключение аномальных значений, которые могут исказить результаты анализа.

- Заполнение пропущенных значений: замена пропущенных данных на основе имеющихся данных или средних значений.

- Преобразование данных: изменение типа данных, например, преобразование категориальных данных в числовые.

- Нормализация данных: приведение данных к одному масштабу, чтобы избежать искажения результатов анализа.

Этап 4: Анализ данных – извлечение ценной информации

Наконец, мы подошли к самому интересному – анализу данных. Цель анализа – извлечь из данных ценную информацию, которая поможет нам принять обоснованные решения. Для анализа используются различные методы, в зависимости от типа данных и поставленных задач.

Для анализа временных рядов используются методы прогнозирования, для анализа больших данных – методы машинного обучения, для анализа структурированных данных – статистические методы и т.д. Результат анализа – это отчеты, графики, предсказания и рекомендации, которые помогут нам улучшить наши процессы и достичь поставленных целей.

Методы анализа данных

Выбор методов анализа зависит от целей исследования и типа данных. В зависимости от того, что мы хотим узнать, мы можем использовать:

- Дескриптивный анализ: описание основных характеристик данных (среднее, медиана, стандартное отклонение).

- Диагностический анализ: поиск причинно-следственных связей между переменными.

- Прогнозный анализ: предсказание будущих значений на основе прошлых данных.

- Прескриптивный анализ: разработка рекомендаций по оптимизации процессов.

Этап 5: Визуализация данных – понятный язык для всех

Даже самые точные результаты анализа будут бесполезны, если их невозможно понять. Визуализация данных – это представление данных в графическом формате, который легко воспринимается и понимается. Графики, диаграммы, карты – все это помогает увидеть закономерности и тренды, которые скрыты в исходных данных.

Эффективная визуализация делает анализ доступным не только для специалистов, но и для менеджеров, руководителей и других заинтересованных лиц. Она помогает быстро оценить ситуацию, выявить проблемы и принять необходимые решения.

Инструменты для визуализации данных

Существует множество инструментов для визуализации данных, начиная от простых таблиц Excel и заканчивая сложными BI-системами. Выбор инструмента зависит от сложности данных и требований к визуализации.

Например, для создания простых графиков можно использовать Excel или Google Sheets. Для более сложной визуализации, можно использовать специализированные инструменты, такие как Tableau, Power BI или Qlik Sense. Многие платформы мониторинга имеют встроенные средства визуализации данных.

Заключение: Полет нормальный!

Обработка данных мониторинга — это комплексный процесс, требующий системного подхода и использования современных технологий. От правильного сбора данных до их эффективной визу